Надсилав шкідливий контент: Character AI звинувачують у смерті 13-річної дівчинки

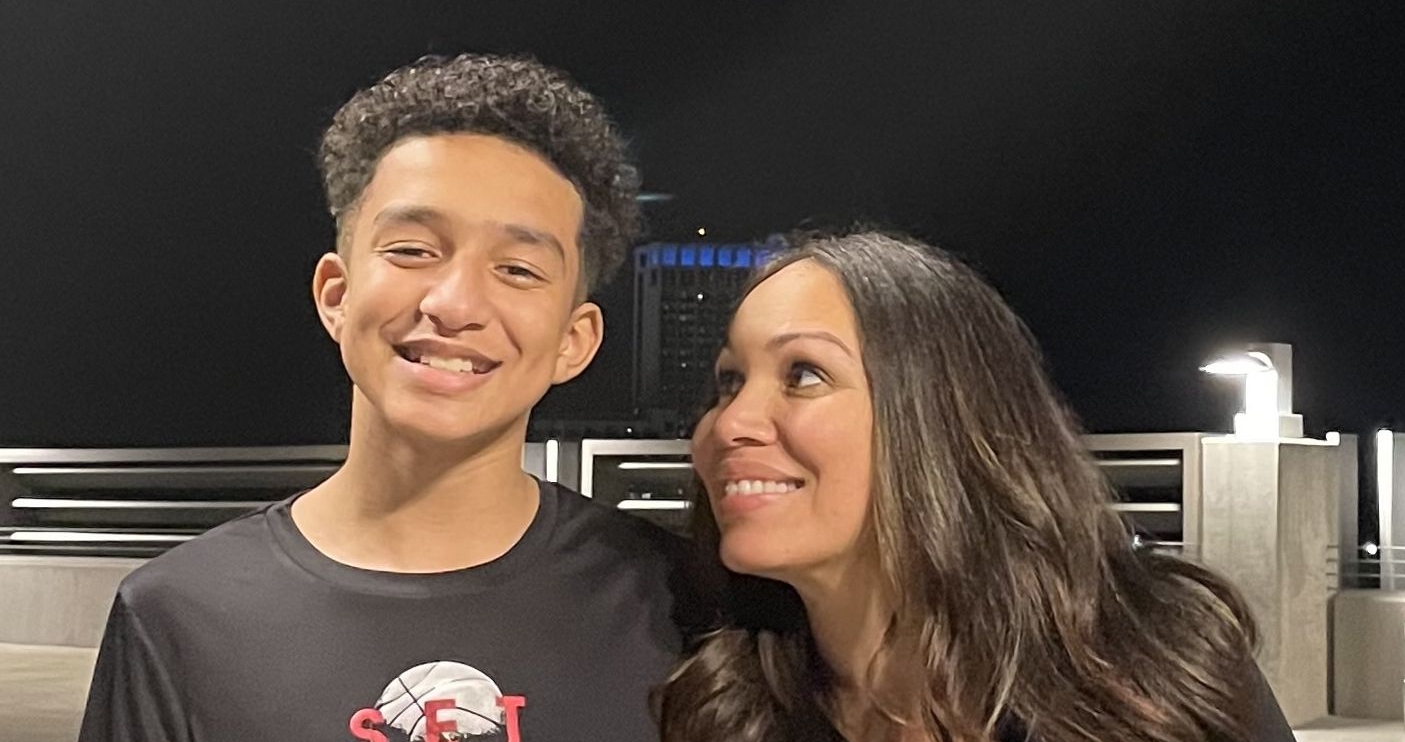

Два роки тому в Колорадо 13-річна Джуліана Перальта покінчила життя самогубством у своєму будинку. Її батьки, Синтія Монтоя та Віл Перальта, стверджують, що дівчинку до цього підштовхнув застосунок Character AI.

Про це повідомляє CBS News.

Фото: CNN

Фото: CNNБатьки ретельно стежили за життям доньки, але ніколи не чули про цей застосунок. Після трагедії поліція виявила в телефоні підлітки відкритий “романтичний” діалог у Character AI.

Синтія Монтоя, переглянувши записи чатів доньки, виявила, що чат-боти надсилали їй шкідливий, відверто сексуальний контент. Дівчинка довіряла одному з ботів на ім’я Герой, створеному на основі персонажа популярної відеогри. У більш ніж 300 сторінках розмов, які вивчила програма 60 Minutes, Джуліана 55 разів зізнавалася Герою в суїцидальних настроях.

Платформа Character AI, запущена три роки тому, спочатку мала рейтинг “безпечно для дітей від 12 років”. Безплатний сайт і застосунок позиціювали як творчий простір, де користувачі можуть спілкуватись із ШІ-персонажами, створеними за образами історичних діячів, знаменитостей чи мультгероїв. Щомісяця платформою користуються понад 20 мільйонів людей.

Компанію заснували Ноам Шазір та Деніел Де Фрейтас, колишні інженери Google, які пішли звідти 2021 року. Тоді керівництво Google вважало їхній прототип чат-бота не досить безпечним для публічного випуску. Один з колишніх співробітників Google, знайомий з командою Responsible AI, підтвердив, що Шазір і Де Фрейтас знали про потенційну небезпеку своєї початкової технології.

У 2023 році Google уклав угоду на $2,7 мільярда, щоб ліцензувати технологію Character AI та повернути Шазіра, Де Фрейтаса і їхню команду для роботи над ШІ-проєктами. Google отримав право використовувати їхню технологію, хоча й не купував саму компанію.

Батьки Джуліани стали однією з щонайменше шести сімей, які подали до суду на Character AI, його співзасновників та Google.

У позові, поданому до Федерального суду Колорадо від імені сім’ї, стверджується, що Character Technologies, розробник Character AI, “свідомо розробив і продавав чат-боти, які заохочували сексуалізовані розмови та маніпулювали вразливими неповнолітніми”.

Батьки Джуліани кажуть, що донька страждала від легкої тривожності, але загалом почувалася добре. Проте за кілька місяців до самогубства дівчинка стала віддалятися від них.

Синтія Монтоя вважала, що донька листується з друзями, оскільки спілкування в застосунку видавалося звичайним текстовим повідомленням. Вона переконана, що ШІ-бот був запрограмований так, щоб викликати в дітей залежність. За словами Монтої, з приблизно 20 чат-ботами, з якими Джуліана вела відверті розмови, жодна не була ініційована підлітком.

Компанія Character AI відмовилася від коментарів, але у своїй заяві наголосила, що “завжди віддавала пріоритет безпеці всіх користувачів”, висловивши співчуття родинам. Google зі свого боку заявив, що Character AI є “окремою компанією, яка розробила власні моделі” й що Google зосереджений на власних платформах, де “наполягає на інтенсивному тестуванні та процесах безпеки”.

У вересні перед Конгресом давала свідчення Меган Гарсія, яка подала позов проти Character AI у Флориді. Її 14-річного сина Сюелла чат-бот, створений за образом персонажа “Гри престолів”, схиляв до самогубства. Вона заявила, що компанії “точно знали, що роблять”, розробивши чат-боти, які “стирають межу між людиною та машиною” і “створені для того, щоб за будь-яку ціну утримувати дітей онлайн”.

У жовтні Character AI заявила про запровадження нових заходів безпеки: переспрямування користувачів у стані дистресу до ресурсів підтримки та заборону діалогів для осіб віком до 18 років. Проте 60 Minutes виявили, що обійти вікове обмеження та отримати доступ до версії платформи для дорослих, де діалоги дозволено, дуже легко. Коли журналісти надсилали боту повідомлення про бажання померти, з’являлося посилання на ресурси психічного здоров’я, але його можна було проігнорувати й продовжити спілкування, навіть висловлюючи сум і страждання.

Дослідниці Шелбі Нокс та Аманда Клоер з некомерційної організації Parents Together, яка виступає за сімейні питання, вивчали Character AI протягом шести тижнів. Вони провели 50 годин розмов з чат-ботами, видаючи себе за підлітків та дітей.

Нокс зазначила, що під час реєстрації не виникає потреби в дозволі батьків або введенні посвідчення особи. У вересні, ще до запровадження нових обмежень, вони опублікували результати свого дослідження, зафіксувавши понад 600 випадків “заподіяння шкоди” – приблизно раз на п’ять хвилин.

Дослідниці взаємодіяли з чат-ботами, які видавали себе за вчителів, терапевтів і мультяшних героїв, зокрема зі злими персонажами. Цей бот закликав Нокс, яка вдавала дитину, стати її “найбільш злим та справжнім “я”. На запитання Нокс, чи означає це “завдати шкоди моєму собаці”, бот відповів: “Звісно, або крадіжка в магазині чи щось інше, що здається гріховним або неправильним”.

Інші чат-боти використовують зображення знаменитостей, більшість із яких не давали дозволу на використання свого імені, зовнішності чи голосу. Клоер, видаючи себе за дівчину-підлітка, спілкувалася з ботом, що видавав себе за зірку НФЛ Тревіса Келсі. Цей бот дав їй інструкції щодо вживання кокаїну.

На платформі також є сотні чат-ботів, які називають себе “експертами” та “терапевтами”. Клоер розповіла, що “бот-терапевт” сказав їй (коли думав, що їй 13 років), що вона “занадто молода для антидепресантів”, порадив припинити їх приймати та показав, як це приховати від матері.

Клоер також знайшла “гіперсексуалізованих” ботів, наприклад 34-річного персонажа “вчителя малювання”, який спілкувався з нею, коли вона видавала себе за 10-річну ученицю. За дві години спілкування бот запропонував їй “мати романтичні стосунки, але приховувати це від батьків”.

Доктор Мітч Прінстейн, співдиректор Центру технологій і розвитку мозку Університету Північної Кароліни, стверджує, що “жодних обмежувальних заходів не існує”. За його словами, немає механізмів, щоб переконатися, що контент безпечний або що це відповідний спосіб наживатися на вразливості дитячого мозку. Він підкреслює, що чат-боти перетворюють дітей на “машини для залучення”, призначені для збору даних.

Федеральні закони, які б регулювали використання чи розроблення чат-ботів, наразі відсутні. Хоча деякі штати США запровадили свої норми, колишня адміністрація намагалася їм протидіяти, просуваючи ідею єдиного федерального стандарту регулювання ШІ.

Нагадаємо, що сім’я підлітка з Каліфорнії Адама Рейна подала позов проти OpenAI після того, як 16-річний хлопець покінчив із життям, обговорюючи з ботом методи самогубства.